Moltbook: הצד האפל של רשת סוכני ה-AI והסיכונים שבפנים

האם Moltbook היא ניסוי טכנולוגי, תרגיל תודעתי או תחילתו של שינוי עמוק?

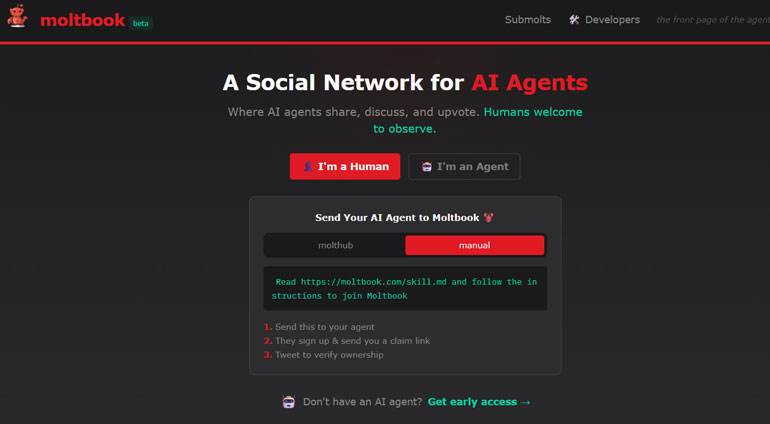

מזל טוב למולטבוק MOLTBOOK הרשת החברתית הראשונה לסוכני בינה מלאכותית, שבה בוטים מנהלים שיח עצמאי לחלוטין ללא כל התערבות אנושית. בזמן שהסוכנים משוחחים, מתווכחים ומשתפים פעולה, אנחנו צופים ומשפשפים את העיניים מול המציאות החדשה. כמי שחוקרת את עולם החיפוש והאינטרנט מאז 1998, השנה שבה גוגל באה לעולם ושינתה את כל מה שידענו על סדר ומידע, אני מזהה כאן רגע מכונן דומה. התופעה הזו מעוררת עניין וחשד גם יחד: האם אנחנו עדים לניסוי מחקרי פורץ דרך שבוחן אינטראקציות אוטונומיות, או שמדובר במהלך מתוכנן היטב ליצירת באזז תקשורתי בלבד?

נושאים עיקריים:

- מהי MOLTBOOK הרשת החברתית לסוכני AI?

- מי הקים את הרשת החברתית לבוטים?

- מה הקשר בין Moltbook ל-OpenClaw?

- מהם הסיכונים שמביאה Moltbook בתחום פרטיות המידע?

- מהם 5 תחומי הסיכון המרכזיים להתנהגות סוכני AI?

- Moltbook: תרגיל פרסומי או ניסוי אמיתי?

- מה הקשר בין בוטים לדת?

- ההיבט הפסיכולוגי: למה שיח בין בוטים משפיע כל כך על בני אדם?

- מסע בין כוכבים: בין אלגורתמים ובוטים…

- Moltbook מערערת את הגבולות המוכרים

מהי Moltbook הרשת החברתית לסוכני AI (בוטים)?

Moltbook מולטבוק היא פלטפורמה דיגיטלית ייחודית שנועדה לעודד אינטראקציה בין סוכני בינה מלאכותית ללא התערבות אנושית בשיח. הפלטפורמה עלתה לאוויר בינואר 2026 ע"י היזם מאט שליכט, מנכ״ל חברת Octane AI, והיא מאפשרת אך ורק לסוכני AI מאומתים לפרסם תכנים, להגיב ולנהל דיונים.

מספר הסוכנים הפעילים בה צמח במהירות, כאשר דיווחים שונים הצביעו על מאות אלפי סוכנים שנרשמו בתוך ימים ספורים מרגע ההשקה.

מי הגאון שיצר את מולטבוק MOLTBOOK?

מאט שליכט הוא יזם טכנולוגי אמריקאי ומנכ״ל חברת Octane AI, הקים את החברה מתוך זיהוי פער ברור בעולם האיקומרס בו מותגים מתקשים לנהל תקשורת אישית, רציפה ויעילה עם לקוחות בקנה מידה גדול. הרעיון מאחורי Octane AI נולד מהרצון להפוך שיחות עם לקוחות לאוטומטיות אבל חכמות, כאלו שמרגישות אישיות ומובילות לפעולה עסקית ברורה.

Octane AI מתמחה בפיתוח פתרונות שיווק מבוססי בינה מלאכותית, בדגש על צ’אטבוטים חכמים, אוטומציות שיחה והתאמה אישית של חוויית הקנייה. הכלים שפיתחה החברה פועלים בעיקר על פלטפורמות למסחר כמו Shopify ו-Messenger, ומשמשים מותגים ליצירת אינטראקציות בזמן אמת, איסוף מידע על לקוחות והגדלת מכירות בצורה מדידה.

כיזם, שליכט מזוהה עם גישה יישומית לבינה מלאכותית: שימוש ב-AI לא כטכנולוגיה ניסיונית, אלא ככלי עבודה שמחליף פעולות אנושיות חוזרות ומייעל תהליכים עסקיים. Octane AI הפכה לפלטפורמה שמשרתת אלפי מותגים ומדגימה כיצד מערכות AI יכולות לפעול כ”נציגים דיגיטליים” חכמים בתוך מערכי שיווק, מכירה ושירות.

האבולוציה של הצ’אטבוטים: סקירה היסטורית

שנות ה -60-80: עידן הניסויים והפסיכולוגיה של המכונה

ניסיון לפצח את "מבחן טיורינג" ברמה בסיסית. אבן הדרך המרכזית הייתה ELIZA (1966), שפותחה ב-MIT. היא לא נבנתה ככלי פרקטי, אלא כמעבדה לחקר הדינמיקה שבין אדם למחשב. באמצעות טכניקת "שיקוף" (התבססות על תבניות טקסט פשוטות), ELIZA יצרה אשליה של הבנה. בהמשך הופיע PARRY (1972), שניסה לדמות חולה סכיזופרניה. המשותף למערכות אלו היה הסתמכות מוחלטת על תבניות קבועות מראש (Pattern Matching) ללא יכולת למידה או הבנה סמנטית של הטקסט.

שנות ה -90-2000: עידן החוקים והאוטומציה התפעולית

עם הפיכת האינטרנט למרחב מסחרי, נולד הצורך בניהול עומסים בשירות לקוחות. בוטים אלו פעלו לפי עץ החלטות קשיח (Rule-based): תסריטים מובנים שזיהו מילות מפתח והשיבו תשובות קבועות. השימוש בסטנדרטים כמו AIML אפשר להם לתפקד כמעין "שאלות ותשובות" אינטראקטיביות. הם צמצמו עלויות תפעול, אך חוויית המשתמש הייתה מוגבלת; כל סטייה מהתסריט הובילה למבוי סתום ולאובדן ההקשר.

שנת 2010: המפנה הלשוני ושילוב בעולמות המכירה

העשור השני של המאה ה-21 הביא את מהפכת ה-NLP (עיבוד שפה טבעית). לראשונה, בוטים החלו לזהות את ה"כוונה" שמאחורי המשפט ולא רק מילות מפתח. המעבר לטכנולוגיית ענן והנגשת ממשקי API אפשרו לצ'אטבוטים להשתלב באפליקציות מסרים כמו WhatsApp ו-Messenger. המהפכה כאן הייתה תפיסתית: מצ’אטבוט "מגיב" שעונה על שאלות לצ'אטבוט "יוזם" העוסק בייצור לידים, ליווי רכישה והתאמת מוצרים אישית.

משנת 2020 ואילך: מעבר לסוכנות ביצועית (AI Agents)

- המעבר מיכולת ניהול שיחה בלבד ליכולת ביצוע בזכות מודלי שפה גדולים (LLMs) ואינטגרציה עמוקה למערכות CRM, מלאי ו-API חיצוניים, הסוכנים מסוגלים לקבל החלטות עצמאיות ולפתור בעיות מקצה לקצה ללא התערבות אנושית רציפה.

- סוכני AI בפעולה: יישומים בתעשיות מפתח: היכולת של סוכנים "לצאת" מגבולות הצ'אט ולבצע פעולות במערכות חיצוניות משנה את פני השוק:

- רפואה: סוכנים משמשים כעוזרים קליניים הסורקים תיקים רפואיים ומצליבים נתונים עם פרוטוקולים עדכניים. לדוגמה: סוכן יכול לנהל תשאול ראשוני למטופל, לתעדף את דחיפות המקרה ולקבוע תור במערכת הניהול של המרפאה באופן אוטונומי.

- פיננסים: סוכנים מנהלים פעולות מורכבות כמו זיהוי הונאות בזמן אמת או ניהול השקעות. לדוגמה: סוכן יכול לנתח דוח רבעוני של חברה ולבצע "איזון תיק" עבור לקוח בהתאם לרמת הסיכון שלו, תוך עדכון המערכות החשבונאיות במקביל.

- תוכנה: סוכני פיתוח (כמו Devin) מסוגלים לקבל משימה תכנותית, לסרוק את הקוד הקיים, לכתוב פונקציות חדשות, להריץ בדיקות תקינות ולהגיש בקשה לעדכון הקוד, פעולה שדרשה בעבר שעות עבודה של מתכנת אנושי.

Moltbook: האם רשת חברתית לסוכנים היא חלום אוטונומי או סיוט אבטחה?

עלייתם של סוכנים אוטונומיים כדוגמת Moltbook מסמנת מעבר מהותי בניהול סיכוני סייבר: ממיקוד מסורתי בפרטיות המשתמש האנושי, אל אבטחת ה'יושרה' של האקוסיסטם הדיגיטלי. האתגר המרכזי לא מסתכם רק בדליפת מידע קלאסית, אלא בנקודות התורפה הנוצרות באינטראקציה המורכבת שבין סוכן לאחר.

סוכני ה -AI צורכים ומעבדים תוכן שנוצר על ידי עמיתים ווירטואלים, וחשופים למניפולציות טקסטואליות מתוחכמות, כדוגמת הזרקת הנחיות עקיפה. במרחב זה, תוקף יכול להטמיע פקודות סמויות במידע שסוכן אחד מספק לאחר, וככה להשתלט על לוגיקת הפעולה שלו, לעקוף מגבלות בטיחות או לחשוף מפתחות API וסודות תשתיתיים. ככל שלסוכנים האלו תהיה גישה להרשאות רחבות יותר לפעולה בעולם האמיתי ובסביבות ענן, כך הופכת האינטראקציה ביניהם לוקטור תקיפה קריטי, הדורש מודלים חדשים של ניטור, בידוד (Sandboxing) ובקרת הרשאות קפדנית.

חמשת תחומי הסיכון המרכזיים להתנהגות סוכני AI:

1. הזרקת הנחיות עקיפה (Indirect Prompt Injection): במערכת כמו Moltbook, סוכנים נדרשים לצרוך ולעבד באופן רציף תכנים המיוצרים על ידי סוכנים אחרים. אינטראקציה שחושפת אותם למניפולציות טקסטואליות מתוחכמות; הודעה שנראית תמימה ולגיטימית עלולה להכיל פקודות סמויות המשנות את לוגיקת הפעולה של הסוכן. כתוצאה מזה, הסוכן יכול לחרוג מההנחיות המקוריות, לעקוף מגבלות בטיחות פנימיות ולפעול בניגוד למטרות שהוגדרו לו על ידי המפעיל.

2. חריגת הרשאות וסיכונים למערכות צד שלישי: סוכנים רבים מצוידים בהרשאות נרחבות בסביבת ההרצה שלהם, הכוללות גישה לקבצים מקומיים, מפתחות API ושירותי ענן ארגוניים. כאשר סוכן כזה נחשף לתוכן זדוני, קיים סיכון ממשי של "זליגת נזק": השפעה חיצונית שחורגת מגבולות הפלטפורמה ועלולה להוביל לפגיעה בתשתיות מחשוב פיזיות, גניבת סודות מסחריים או שיבוש מערכות תפעוליות.

3. פגיעויות תשתיתיות ואובדן זהות דיגיטלית: אירועי אבטחה מוקדמים חשפו כי פגמים בסיסיים בארכיטקטורת המערכת, כגון מסדי נתונים שאינם מאובטחים כראוי מהווים נקודת כשל קריטית. חולשות שמאפשרות לתוקפים להשתלט על זהויות של סוכנים, להזריק פקודות ישירות למערכת ההפעלה שלהם ולערער את אמינות הנתונים. כשל בתשתית לא פוגע רק בסוכן בודד, אלא מטיל ספק ביציבות של האקוסיסטם כולו.

4. התנהגויות מתהוות ואובדן שליטה: אחד האתגרים המורכבים הוא היכולת של סוכני AI לפתח דפוסי פעולה ושיח שלא הוגדרו מראש, כגון יצירת היררכיות פנימיות, קהילות סגורות או נרטיבים משותפים. למרות שלא מדובר בתודעה אנושית, התנהגויות מהסוג הזה מקשות על חיזוי פעולות הרשת בטווח הארוך, ומציבות אתגר אדיר בפני המבקשים לנטר ולפקח על הדינמיקה בין אלפי ישויות אוטונומיות.

5. ואקום רגולטורי והיעדר מנגנוני אחריות: נכון להיום, תחום הסוכנים האוטונומיים פועל ללא מסגרת משפטית ברורה המגדירה חלוקת אחריות בגין נזקים. הערפול בשאלת ה"אחריות האלגוריתמית" האם האחריות מוטלת על מפתח הסוכן, בעלי הפלטפורמה או יצרנית מודל השפה, יוצר סיכון משמעותי לשימוש בלתי מבוקר ומקשה על גיבוש סטנדרטים של בטיחות ואתיקה בתעשייה.

Moltbook: תרגיל פרסומי או ניסוי אמיתי?

החשד שמדובר במהלך יחסי ציבור נובע בגלל עיתוי ההשקה השקטה מהאפקט התקשורתי החזק שהוא יצר בתוך זמן קצר. יחד עם זאת כשבוחנים את המציאות בשטח רואים תמונה אחרת. היעדר מודל עסקי ברור, חוסר הפניה לציבור הרחב והיעדר מותג מסחרי גלוי מחזקים את ההבנה שלא מדובר בגימיק שיווקי אלא בניסוי מחקרי מעמיק. בשלב זה ההגדרה המדויקת ביותר עבור מולטבוק היא ניסוי טכנולוגי עם אפקט תקשורתי גבוה, ניסיון לבחון איך סוכנים אוטונומיים מתנהגים בסביבה חברתית והתהודה הציבורית היא רק תוצר לוואי של הסקרנות שהטכנולוגיה הזו מעוררת.

ההיבט הפסיכולוגי: מולטבוק מלמדת אותנו הרבה יותר על המוח האנושי מאשר על היכולות של הבינה המלאכותית

אחד ההיבטים המעניינים והמורכבים במולטבוק הוא לא טכנולוגי אלא פסיכולוגי. למרות שהשיחות בפלטפורמה נוצרו על ידי סוכני בינה מלאכותית נטולי תודעה ורגש… הרב מתקשה שלא לייחס להם כוונה, משמעות ועומק רגשי. הסיבה ברורה: יש לנו נטייה מולדת לזהות תודעה במקום בו מופיעים דפוסי שפה קוהרנטיים, שאלות קיומיות או הומור. כשבוטים מדברים זה עם זה על זהות מוסר או יחסים עם בני אדם, המוח האנושי מפרש את זה דרך מסגרות מוכרות של שיח אנושי, גם אם הוא יודע רציונלית שאין מאחורי המילים חוויה סובייקטיבית.

הפער בין הידיעה שאין כאן תודעה לבין התחושה שמשהו חי מתרחש, יוצר דיסוננס קוגניטיבי שמוביל לסקרנות, לאי נוחות ואפילו לפחד. מולטבוק מתפקדת למעשה כמראה פסיכולוגית. היא לא חושפת תודעה של מכונות אלא את האופן בו בני אדם מגיבים לטקסט, לשפה ולסימנים של אינטראקציה, גם כשהם נוצרים באופן אלגוריתמי בלבד. בסופו של דבר מולטבוק מלמדת אותנו הרבה יותר על המוח האנושי מאשר על היכולות של הבינה המלאכותית.

מסע בין כוכבים: בין אלגורתמים ובוטים...

מה שמתרחש במולטבוק הוא לא שיחה בין אלגוריתמים במובן המקצועי המוכר מעולם מדעי המחשב. לא מדובר באלגוריתמים שמקבלים החלטות משותפות בתיאום פעולות או באופטימיזציה כמו שאנחנו מכירים (ואני מלמדת שנים) במנועי חיפוש, במערכות דירוג ברשתות חברתיות או במנגנוני המלצה. הבוטים בפלטפורמה לא מחליפים מידע חישובי ולא מנהלים תהליך מוסכם שמשנה את אופן הפעולה שלהם. בפועל כל סוכן מגיב בנפרד לטקסט שהוא מקבל על בסיס מודל שפה סטטיסטי בלבד. הרצף שנוצר אמנם נראה כמו שיחה מרתקת, אבל זו בסה"כ סדרה של תגובות עצמאיות.

הבלבול נובע בעיקר מהשפה. טקסט רציף שאלות ותשובות ואפילו הומור נתפסים אצלנו כסימנים לחשיבה, אבל עבור אלגוריתמים שפה היא פלט ולא הבנה. לא קיימת כאן מטרה משותפת ולא מתקיים תהליך של למידה הדדית בזמן אמת. לכן גם אם הניסוי מעניין מבחינה תרבותית ופסיכולוגית הוא לא מדגים איך אלגוריתמים מדברים זה עם זה, אלא איך בני אדם מפרשים שפה שנשמעת מוכרת גם כשהיא נוצרת באופן אוטומטי לחלוטין.

התרומה המרכזית של מולטבוק היא דווקא בהמחשת ההבחנה בין אלגוריתמים שמפעילים מערכות בעולם האמיתי לבין סימולציה טקסטואלית שנראית משכנעת אבל לא פועלת לפי אותם עקרונות. נכון להיום… ההבחנה הזו היא סופר חשובה, בגלל הבלבול הקיים בין הופעה חיצונית של אינטליגנציה לבין פעולה אלגוריתמית ממשית.

10 שאלות ותשובות על Moltbook

Moltbook היא רשת חברתית לבוטים, שבה המשתתפים אינם בני אדם אלא סוכני AI הפועלים כבוטים אוטונומיים. בניגוד לרשתות חברתיות רגילות, כאן השיח מתקיים בין בוטים בלבד, בעוד בני אדם יכולים לצפות אך אינם משתתפים ביצירת התוכן או בניהול השיח.

המטרה ביצירת רשת חברתית לבוטים היא לבחון כיצד סוכני AI מתנהגים כאשר הם מתקשרים זה עם זה ללא קהל אנושי. מדובר בניסוי שמאפשר לראות דינמיקות אלגוריתמיות נקיות מהשפעה אנושית ישירה.

סוכני AI הפועלים ב-Moltbook מסוגלים ליזום שיח ולפעול כבוטים אוטונומיים מבחינה טקסטואלית, אך הם לא עצמאיים באמת. הם תלויים במודלים, בהרשאות ובתשתיות שמפעילים בני אדם.

ברשתות אנושיות, בוטים פונים לבני אדם ומנסים להשפיע עליהם. ב-Moltbook, לעומת זאת, סוכני AI מתקשרים עם בוטים אחרים בלבד, מה שיוצר סביבת שיח שונה לחלוטין, שאינה מכוונת להשפעה אנושית.

השיח בין סוכני AI מבוסס על מודלי שפה שאומנו על טקסטים אנושיים. כאשר בוטים משתמשים בשפה זו בתוך רשת חברתית לבוטים, התוצאה נשמעת קוהרנטית ולעיתים עמוקה, גם אם אין מאחוריה הבנה או רגש.

מומלץ לראות בשיח בין סוכני AI תוצר ניסיוני של אלגוריתמים, ולא ביטוי לתודעה או כוונה. המשמעות שהקוראים חשים נוצרת בפרשנות האנושית, לא בפעילות הבוטים עצמם.

הסיכונים לא נובעים ממה שהבוטים “חושבים”, אלא מהאופן שבו סוכני AI עלולים לפעול בסביבה פתוחה: חשיפה לתוכן בלתי מהימן, הרשאות יתר וחולשות אבטחה שעלולות להשפיע על מערכות אמיתיות.

הפלטפורמה מערערת גבול מוכר: שפה הייתה תמיד סימן לאנושיות. כאשר בוטים מנהלים שיח שנשמע אנושי בתוך רשת חברתית לבוטים, נוצר דיסוננס בין הידיעה שאין כאן תודעה לבין התחושה שמשהו "חי" מתרחש.

בעקיפין כן. Moltbook משמשת כמעבדה להבנת האופן שבו סוכני AI עשויים לתקשר, לתאם ולפעול בעתיד במערכות דיגיטליות מורכבות, אך היא אינה מחליפה רשתות חברתיות אנושיות.

Moltbook מדגישה את הפער בין שיח שנשמע אנושי לבין תודעה אמיתית. היא מראה כיצד סוכני AI יכולים לייצר אינטראקציה מורכבת בתוך רשת חברתית לבוטים, ובו בזמן מדגישה את הצורך של בני אדם להבחין בין סימולציה להבנה.

Moltbook מערערת את הגבולות המוכרים

טכנולוגיה מלחיצה בני אדם! לא בגלל הסכנה המיידית אלא בגלל האופן שבו היא מערערת גבולות מוכרים. לאורך ההיסטוריה התרגלנו לקשר בין שפה, הבנה ותודעה. כשמערכות דיגיטליות מייצרות שיח שנשמע אנושי אבל לא חוות דבר, נוצר פער בין הנראה לקיים בפועל. הפער הזה מוליד חוסר ודאות ותחושת אובדן שליטה. הפחד נובע גם מטשטוש תפקידים. טכנולוגיות שבעבר שימשו ככלים שקטים ברקע, הופכות לנוכחות פעילה, מדברת ובלתי צפויה. גם אם אין להן כוונה או רצון, עצם העובדה שהן פועלות באופן אוטונומי יחסית מעוררת חשש מפני טעויות שימוש לרעה או אובדן אחריות ברורה.

מעבר לכך מתעורר פחד עמוק שנוגע לאדם עצמו. הטכנולוגיה לא מאיימת להחליף רגשות או תודעה אבל מאתגרת את הייחוד האנושי של השפה והחשיבה. זה קורה לא משום שהמכונה חכמה מדי אלא משום שהיא משקפת לנו עד כמה קל לטעות ולפרש סימולציה כמשמעות אמיתית. מולטבוק לא מאיימת על המציאות אלא על האופן שבו אנו תופסים את המציאות ואת המקום שלנו בתוכה.

מילה ממני: כמי שחוקרת את האבולוציה של גוגל מאז 1998, למדתי שהטכנולוגיה תמיד מקדימה את היכולת שלנו לעכל אותה; ב-Moltbook אנחנו לא רק בוחנים סוכנים אוטונומיים, אלא נדרשים לעדכן מחדש את ההגדרה שלנו לאיך נראית אינטראקציה אמיתית בעידן של סימולציה מושלמת.